大型数据库(7)--- Storm安装与配置

安装说明

安装环境

虚拟机:VirtualBox-6.1.18

操作系统:Ubuntu16.04LTS

集群情况:

| 主机名称 | hadoop版本 | ZooKeeper版本 | IP地址 |

|---|---|---|---|

| hadoop-master | 2.7.3 | 3.6.3 | 192.168.56.1 |

| hadoop-slave1 | 2.7.3 | 3.6.3 | 192.168.56.2 |

| hadoop-slave2 | 2.7.3 | 3.6.3 | 192.168.56.3 |

本次安装的Storm

Storm版本:2.3.6

下载地址:apache-storm-2.2.0.tar.gz

其他:Storm官网 、查看不同版本、官方文档

都准备就绪后,我们就接着往下开始安装吧!

不知道怎么准备的,我之前的文章 也许可以给你带来一些参考哦 - - - ☞ 搭建hadoop集群

大型数据库(6)— ZooKeeper安装与配置.

开始安装

- 我的两个基础软件Hadoop、Java 分别是在/usr/hadoop 和 /usr/java下

- 其他的都安装在 ~/Hadoop 的文件夹下

- Storm不仅需安装在hadoop-master下,还需部署在slave机上

安装并配置Storm

解压

1 | cd ~/下载 |

配置

storm.yaml

1 | // 将此处的部分改为: |

本机测试

此时,您可以在master主机上,稍微试试水…

1 | cd ~/Hadoop/storm-2.2.0/bin |

输入

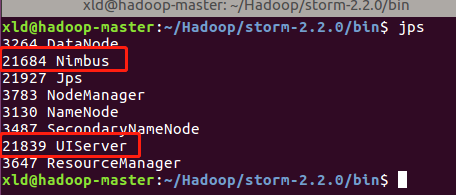

$ jps将会看到

打开网页http://192.168.56.1:8888/可以看到

这样,你的master机基本上就配置好了!

我们先将其停掉,继续往后配置!

将Storm安装文件复制到Slave节点

1 | cd ~/Hadoop |

启动Storm

// slave 单纯启动 supervisor 即可,UI 在 hadoop-master 查看

1 | // 首先是保证 各个机器 都开启了 zookeeper |

hadoop-master 成功启动

浏览器打开http://192.168.56.1:16010往下滑 可以看到以下页面

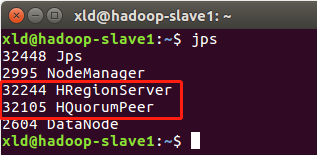

hadoop-slave1、hadoop-slave2 启动成功

其他

关于怎么结束掉上面几个的运行,好像没法像什么好的方法

我自己实验通常就暴力点 $ kill -9 pid 简单粗暴!

参考文章:

W3Cschool Apache Storm安装

Storm集群安装部署步骤【详细版】

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 细粒丁の小窝!

评论